L’IA ÉCRIT MIEUX QUE SHAKESPEARE ET MOLIÈRE,

ET EN PLUS, ELLE TRICHE SANS FAILLE

Visionner la vidéo

Sources

- AI-generated poetry is indistinguishable from human-written poetry and is rated more favorably | Scientific Reports

- The More You Automate, the Less You See: Hidden Pitfalls of AI Scientist Systems

- DAMAGE:Detecting Adversarially Modified AI Generated Text

- Deezer and Ipsos study: AI fools 97% of listeners

Les détecteurs d’IA échouent techniquement, discriminent humainement et détournent l’éducation de sa mission : former, plutôt que surveiller.

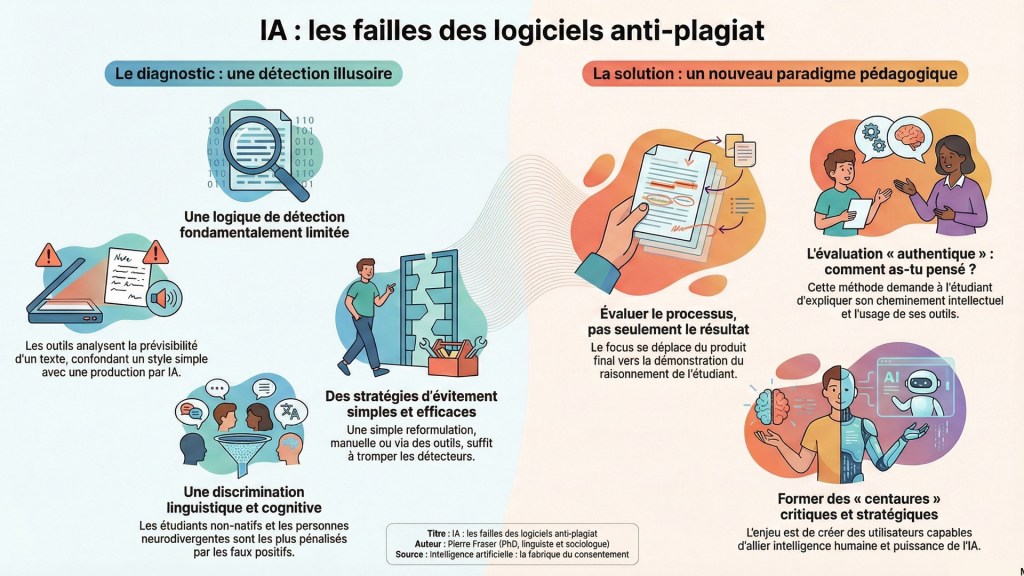

L’irruption de l’intelligence artificielle générative dans le champ éducatif n’a pas seulement bouleversé les pratiques pédagogiques. Elle a surtout ouvert un nouveau front idéologique. Très vite, un « marché de la défiance » s’est structuré, prospérant sur une promesse simple, rassurante, presque magique : détecter la triche, démasquer la machine, restaurer l’ordre académique. À la clé, une industrie d’outils supposément infaillibles. Dans les faits, c’est une illusion coûteuse. Et une impasse. Car la croisade contre la détection automatique repose sur un malentendu technique majeur. Les détecteurs analysent la « perplexité » d’un texte, c’est-à-dire son degré de prévisibilité statistique. Un style jugé trop lisse, trop régulier, trop propre devient suspect. Problème : cette logique confond la machine avec la banalité. Elle est structurellement incapable de résister à la moindre stratégie d’évitement. Une reformulation élémentaire, parfois même manuelle, suffit à faire s’effondrer les taux de détection. La course à l’armement est engagée. Elle est déjà perdue.

Les attaques les plus sophistiquées ne font qu’enfoncer le clou. Des techniques comme PDFuzz contournent intégralement les systèmes de détection en modifiant l’ordre d’extraction des caractères dans un fichier PDF, sans toucher au rendu visuel. Le texte reste identique à l’œil humain. Il devient invisible pour la machine. D’autres méthodes, plus triviales mais redoutablement efficaces, exploitent la logique même des détecteurs : on leur soumet un texte, on observe leurs faiblesses, puis on les utilise comme boussole pour produire une « paraphrase adversaire ». Résultat : un contenu artificiel qui coche toutes les cases de l’authenticité humaine. Ironie ultime.

Mais l’échec n’est pas seulement technique. Il est profondément humain. Ces outils ne traquent pas l’IA ; ils pénalisent les styles simples, directs, normés. Autrement dit, ils frappent d’abord les étudiants non-natifs, dont l’écriture est souvent plus fonctionnelle que stylistiquement flamboyante. Ils touchent aussi les personnes neurodivergentes, pour qui la régularité syntaxique est une stratégie de clarté, non un indice de fraude. Le taux de faux positifs devient alors vertigineux. Et avec lui, une discrimination linguistique et cognitive déguisée en rigueur académique.

Face à cette surveillance défaillante, les usages s’adaptent. Rapidement. Les forums étudiants débordent déjà de recettes : reformulations en chaîne, traductions croisées, insertion volontaire d’erreurs, ton faussement relâché. Oui, la qualité du texte en souffre parfois. Mais les algorithmes, eux, tombent dans le panneau. En contexte universitaire, l’incapacité chronique des détecteurs à identifier les productions hybrides, c’est-à-dire — ni totalement humaines, ni totalement artificielles — rend leur usage probatoire presque inutile. On accuse, sans pouvoir prouver. On soupçonne, sans comprendre.

Dès lors, persister dans cette logique relève moins de la protection pédagogique que du réflexe disciplinaire. Une posture d’accusateur. À l’inverse, un changement de paradigme s’impose. Non pas surveiller davantage, mais évaluer autrement. Certains cadres émergent déjà, notamment au Québec, en faveur d’une évaluation dite « authentique ». Le centre de gravité se déplace : du résultat vers le processus. Non plus « qu’as-tu rendu ? », mais « comment as-tu pensé ? ». Montre ton raisonnement. Explique ton chemin.

L’enjeu n’est pas d’éradiquer l’IA. Il est d’apprendre à vivre avec elle. De former des utilisateurs responsables, critiques, stratégiques. Des « centaures », capables de conjuguer intelligence humaine et puissance algorithmique sans abdication intellectuelle. Abandonner les détecteurs n’est donc pas une capitulation. C’est un choix. Un choix pédagogique, politique et éthique. Et peut-être la condition minimale pour préparer l’éducation aux réalités du XXIᵉ siècle.

INTELLIGENCE ARTIFICIELLE

© Pierre Fraser (PhD, linguiste et sociologue), 2015-2025